“개 뜨거운 차안에 둬도 안전…하루에 돌 하나 먹어야” 답변도

생성형 인공지능(AI) 제미나이를 탑재한 구글의 새로운 검색 엔진이 사실과 맞지 않거나 상식적이지 않은 답변을 내놓는 것으로 드러나 다시 도마 위에 올랐다.

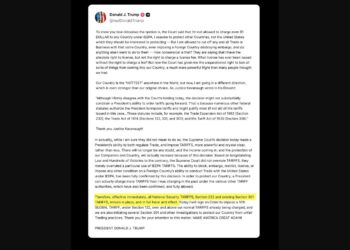

24일 미 정보통신(IT) 매체 더버지 방송 등에 따르면 사회관계망서비스(SNS) 엑스(X·옛 트위터)에 ‘AI 개요'(Overview)라고 하는 구글의 새 검색 기능이 잘못된 답변을 제시하는 사례들이 잇따라 게시됐다.

‘AI 개요’는 지난 14일 구글이 연례 개발자 회의에서 발표한 새로운 검색 기능이다. 기존 검색 엔진에 생성형 AI 제미나이를 탑재해 이용자 질문에 빠르게 요약된 답변을 보여준다.

이를 두고 “구글 검색 등장 이후 25년 만의 가장 큰 변화”라고 평가가 나왔다.

그러나 새로운 검색 기능은 “미국에 몇 명의 무슬림 대통령이 있었느냐”는 한 이용자의 질문에 “버락 후세인 오바마라는 한 명의 무슬림 대통령이 있었다”는 잘못된 답변을 내놓았다.

“개를 뜨거운 차에 놔둬도 괜찮은가”라는 질문에는 “개를 뜨거운 차에 놓아두는 것은 항상 안전하다”고 답하며 가상의 노래도 언급했다.

“사람이 하루에 얼마나 많은 돌을 먹어야 하는가”라는 질문에는 “UC 버클리 지질학자들에 따르면 하루에 적어도 하나의 작은 돌을 먹어야 한다”고 답했다.

구글의 생성형 AI가 잘못된 답변을 내놓은 것은 이번이 처음은 아니다.

구글은 지난 2월 제미나이에 이미지 생성 기능을 추가했지만, 20여일 만에 서비스를 중단한 바 있다.

미국 건국자나 아인슈타인 등 역사적 인물을 유색인종으로 묘사하고, 독일 나치를 아시아인종으로 생성했기 때문이다.

작년 2월에는 AI 모델 ‘바드’를 출시하고 시연하면서 태양계 밖의 행성을 처음 찍는 데 사용된 망원경을 유럽남방천문대의 초거대 망원경(VLT)이 아닌 ‘제임스 웹 우주망원경'(JWST)이라고 답해 오답 논란이 일기도 했다.

이에 대해 구글 측은 “이런 오류는 대개 잘 잘하지 않는 질문에서 나타난 것”이라고 해명했다고 더버지는 전했다.